多年来,AI 和机器学习(ML)重塑了各行各业,赋予了人们强大的能力,解决了许多复杂的全球性问题。这些具有变革性的力量,过去被称为 HPC(高性能计算),已经推动了各种规模的组织进行数字化转型,不仅提高了生产力和效率,还增强了解决问题的能力。

随着深度学习和神经网络支持的高度创新的生成式AI模型的涌现,游戏规则正在被进一步颠覆。这些数据和计算密集型机器学习和生成式 AI 应用的增加,对数据中心基础设施提出了前所未有的要求,需要可靠的高带宽、低延迟数据传输、更高的布线和机架功率密度,以及先进的冷却方法。

高级AI要求重新思考数据中心设计

随着数据中心为生成式AI 做准备,用户需要创新、强大的网络基础设施解决方案,以帮助他们轻松设计、部署和扩展后端、前端和存储网络架构,以适应复杂的高性能计算AI 环境。

NVIDIA 深度学习推理平台示例

NVIDIA 深度学习推理平台示例

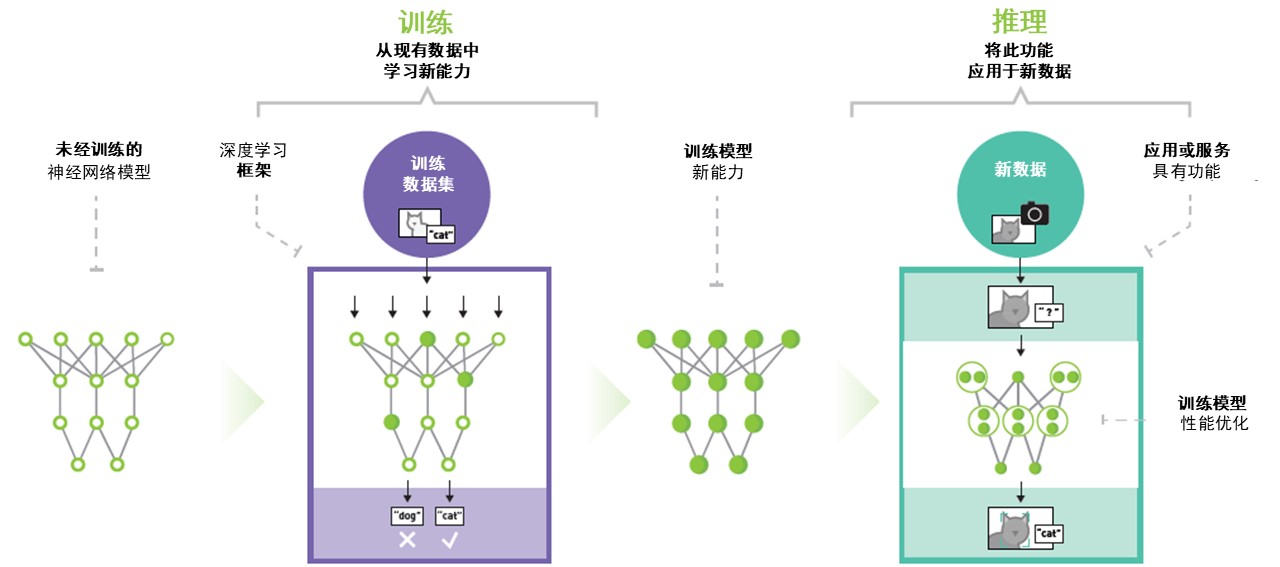

加速的生成式AI和机器学习模型包括训练(学习新能力)和推理(将此能力应用于新数据)。这些深度学习和神经网络模仿人脑的架构和功能,通过分析大量复杂数据集中的模式、细微差别和特征来学习和生成新的原创内容。大型语言模型(LLM),例如 ChatGPT 和 Google Bard,就是这些GenAI模型在大量数据上训练以理解和生成合理的语言响应的示例。传统的通用处理器(CPU) 在顺序执行控制和输入/输出操作时,无法有效地并行从各种来源获取大量数据并快速处理。

因此,加速的机器学习和生成式AI模型依赖于图形处理单元(GPU),这些GPU使用加速并行处理来同时执行数千个高吞吐量计算。基于 GPU 的单个服务器的计算能力可以与数十台基于CPU的传统服务器的性能相媲美!

西蒙AI方案已就绪

西蒙处于生成式AI变革的前沿,通过与我们的客户和合作伙伴的合作,我们开发了一系列下一代AI解决方案,随时准备支持您的部署。